本项目需要使用以下技术:

1. 前端Echarts开源库,使用Python编辑器;

2. 后端HTTP服务器,基于Python实现,使用Pycharm或VSCode编辑器;

3. 数据传输格式为JSON;

4. 数据源类型为JSON文件。实际开发需求中,支持定制HTTP API接口方式或其他各种类型的数据库,如PostgreSQL、MySQL、Oracle、Microsoft SQL Server、SQLite、Excel表格等。

5. Flask web网站的框架搭建及编码实现:

6. 前端HTML代码——页面整体布局;

7. 前端JS代码——Echarts option设置;

8. JSON数据通信格式定义;

9. 前端数据控制;

10. 后端Flask服务器。

IT行业招聘数据分析与可视化是一项重要的研究工作,可以帮助企业了解市场需求、优化招聘策略,同时也可以帮助求职者了解行业趋势、选择合适的职位。下面是一个可能的方案:

1. 数据收集:收集IT行业的招聘数据,包括职位名称、薪资范围、工作经验要求、技能要求等信息。可以通过爬虫技术从招聘网站、社交媒体等渠道获取数据。

2. 数据清洗与整理:对收集到的数据进行清洗和整理,去除重复数据、缺失值等,确保数据的准确性和完整性。

3. 数据分析:使用统计分析和机器学习等技术对数据进行分析。可以分析不同职位的需求量、薪资水平、技能要求的变化趋势等。还可以利用聚类分析、关联规则挖掘等方法找出相关性和规律。

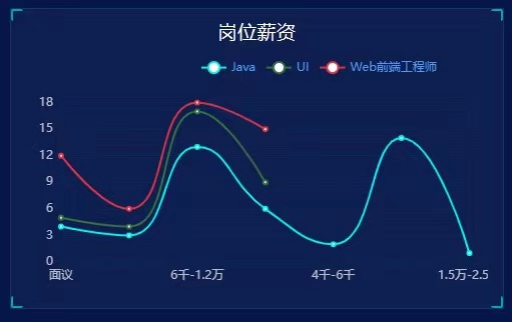

4. 可视化展示:利用数据可视化工具,如Tableau、Python的matplotlib、seaborn等,将分析结果以图表、热力图、地图等直观形式展示出来。可以制作招聘趋势图、薪资分布图、技能关联图等,方便用户理解和利用分析结果。

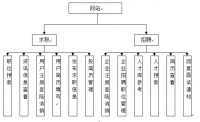

5. Web应用程序开发:使用Flask框架搭建一个Web应用程序,将数据分析和可视化结果呈现给用户。可以提供数据查询、筛选、对比等功能,使用户可以根据自己的需求获取特定的招聘数据和分析结果。

6. 持续更新和优化:定期更新数据,并对分析方法和可视化展示进行优化。可以根据用户反馈和需求进行改进,提高用户体验和分析效果。

这样的研究项目可以为企业招聘部门、人力资源机构提供重要的决策支持,同时也为求职者提供有价值的就业指导和信息参考。

研究目的:分析IT行业的招聘数据,并通过可视化的方式展示分析结果,帮助企业和求职者更好地了解和应对市场需求。

开发背景:随着互联网的普及和技术的快速发展,IT行业的人才需求不断增长。因此,准确了解当前IT行业的招聘情况对于企业和求职者都非常重要。随着信息技术的发展,大数据分析已经成为了各行各业的重要工具。招聘行业同样面临着海量数据的挑战,这些数据包括招聘信息、求职者信息、招聘平台数据等。如何对这些数据进行有效分析,发现其中的规律和趋势,成为了提高招聘效果的关键。同时,数据可视化作为沟通数据的一种有效方式,能够将分析结果直观地呈现出来,进一步提高了数据利用的效率。

国外研究现状分析:国外已经有一些关于数据分析与可视化在招聘领域的研究。可以参考和借鉴这些研究成果,将其应用到国内的情况中。

在国外,大数据和人工智能技术在招聘领域的应用已经相对成熟。许多大型招聘平台和人力资源企业都建立了先进的数据分析系统,通过算法和模型对招聘数据进行深入挖掘,从而发现招聘规律、优化招聘策略等。同时,这些企业也十分注重数据可视化技术的应用,通过图表、图像等方式将分析结果直观地呈现出来,以便制定更加精确的招聘策略。

国内研究现状分析:

相比之下,国内IT行业在招聘过程中的数据分析与可视化应用相对较少。大多数企业仍采用传统的招聘方式,缺乏对数据的充分利用和分析。然而,随着国内招聘市场的逐渐成熟和大数据技术的发展,越来越多的企业开始关注数据分析与可视化在招聘中的应用。

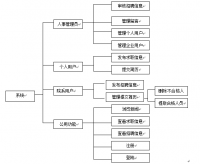

需求分析:根据实际需求,需求分析阶段将明确需要分析的数据来源、分析的指标和展示的方式。根据国内外的研究现状,我们可以得出以下需求:

- 高效地收集和整理招聘数据,包括职位发布量、薪资水平、应聘者性别比例等。

- 利用统计学方法对招聘数据进行深入分析,挖掘潜在的规律和趋势。

- 将分析结果以图表、地图等形式进行可视化展示,便于企业决策者直观地了解招聘市场的情况。

- 结合机器学习算法,预测候选人的能力和潜力,提高招聘效率和成功率。

方案分析:通过采集和整理IT行业的招聘数据,使用数据分析技术对数据进行深入挖掘,提取有价值的信息,并采用可视化的方式展示这些信息,例如制作数据图表、热力图等。

- 整合多渠道数据:将来自不同渠道的招聘数据进行整合,确保数据的全面性和准确性。

- 建立数据仓库:通过建立数据仓库,对数据进行清洗、分类和存储,为后续分析提供基础。

- 运用机器学习算法:采用机器学习算法对招聘数据进行挖掘,发现其中的规律和趋势。

- 制定可视化策略:根据分析结果,制定相应的可视化策略,包括图表、图像等方式。

可行性分析:评估项目的可行性,包括技术可行性、时间成本、资源需求等方面的考虑。考虑到IT行业的特点和现有技术水平,本次研究的可行性较高。以下是一些可行性分析:

- 技术支持:随着大数据和人工智能技术的发展,现有的数据分析工具和可视化技术已经相对成熟,能够满足本次研究的需求。

- 数据可得性:随着招聘平台的普及和信息化程度的提高,招聘数据已经具有一定的可得性。

- 实际应用价值:本次研究提出的解决方案具有实际应用价值,能够为企业提供有效的数据分析和可视化支持,提高招聘效果和效率。

数据可视化:使用数据可视化工具,如Tableau、Python的matplotlib、seaborn等,将分析结果以直观、易懂的图形方式展示出来,帮助用户更好地理解数据。

- 图表展示:通过制作各种图表(如折线图、柱状图、散点图等),展示招聘过程中的各项数据。

- 图像展示:通过制作各种图像(如饼图、雷达图、热力图等),展示不同维度的数据关系。

- 可视化交互设计:通过设计可视化的交互功能(如筛选、排序、点击等),提高用户对数据的理解和操作效率。

- 数据故事讲述:通过编写数据故事,将数据分析结果以故事的形式呈现出来,提高可视化的吸引力和可理解性。

Flask框架搭建:使用Flask框架搭建一个Web应用程序,将数据分析和可视化结果呈现给用户,用户可以通过浏览器访问该应用程序,进行交互和查询。

创新点:本研究的创新点在于结合数据分析和可视化技术,针对IT行业的招聘数据进行深度挖掘和分析,并将结果通过Flask框架搭建的Web应用程序进行展示,实现对招聘市场的全面了解和即时查询。这将提供有力的支持和参考,帮助企业和求职者做出更明智的决策。

在进行IT行业招聘数据爬取时,可以考虑以下步骤:

- 确定数据源:选择一个或多个招聘网站作为数据源。常见的IT招聘网站包括智联招聘、前程无忧、猎聘网等。可以根据需求选择适合的网站进行数据爬取。

- 分析网页结构:仔细分析选定的网站的网页结构,了解招聘信息所在的具体位置、标签、类名等。这将有助于编写爬虫程序以提取所需的数据。

- 编写爬虫程序:使用Python等编程语言,使用相关的库和模块(如beautifulsoup、requests、selenium等)编写爬虫程序。程序可以模拟用户在网页上的操作,从而获取所需的招聘信息。

- 爬取数据:通过编写的爬虫程序,可以开始获取招聘数据。程序访问选定的招聘网站,按照设定的规则批量爬取招聘信息页面,并提取相应的字段,如职位名称、公司名称、工作地点、薪资待遇、技能要求等。

- 数据清洗与整理:对爬取到的数据进行清洗和整理,去除重复数据、处理空值和异常值等。可以使用Python的pandas等数据处理库进行数据清洗和整理操作。

- 数据存储:将清洗整理后的数据存储到数据库或文件中,以便后续的数据分析和可视化处理。可以选择常用的数据库,如MySQL、MongoDB等,或者保存为CSV、Excel等格式的文件。

- 定时爬取:如果需要定期获取最新的招聘数据,可以设置定时任务或使用调度框架,定期运行爬虫程序,以保持数据的及时更新。

IT行业招聘数据分析与可视化数据预测模型

IT行业招聘数据分析与可视化数据预测模型包括以下几个方面:

- 数据采集和处理:通过各种渠道收集和整理IT行业招聘市场的数据,包括职位发布量、薪资水平、应聘者性别比例等。同时,对收集到的数据进行清洗和预处理,确保数据的准确性和完整性。

- 数据分析和建模:运用统计学方法对招聘数据进行深入分析,挖掘潜在的规律和趋势,如职位发布量、薪资水平、应聘者性别比例等。同时,可以使用机器学习算法(如聚类、分类、回归等)对招聘数据进行分析,预测候选人的能力和潜力。

- 数据可视化展示:通过图表、地图等形式将分析结果呈现出来,以便于企业决策者直观地了解招聘市场的情况。同时,可以结合机器学习算法,预测候选人的能力和潜力,提高招聘效率和成功率。

- 数据预测模型:根据数据分析和建模的结果,构建出一系列数据预测模型,以便企业可以根据市场趋势和需求情况,制定更加精准的招聘策略。

- 实时监测和更新:随着市场的变化和发展,需要对数据预测模型进行实时监测和更新,以保证其准确性和有效性。

数据爬取开发过程:

- 抓取网页:通过使用Python等编程语言,利用requests、BeautifulSoup等库来抓取招聘网站、社交媒体等网页,获取其中的数据信息。

- 模拟浏览器:在抓取网页时,需要模拟浏览器的行为,包括访问网页、输入关键词、点击按钮等操作。可以使用Selenium、Puppeteer等工具模拟浏览器行为,以获取更加准确的数据信息。

- 爬取API数据:有些招聘网站和社交媒体提供了API接口,可以通过调用API来获取数据信息。可以使用Python中的requests库或者其他API爬虫库来访问API接口,获取数据信息。

- 多线程爬取:为了提高数据爬取的效率,可以使用Python中的多线程技术,通过多线程、多进程等方式加速数据爬取过程。

- 数据清洗和存储:获取到的数据需要进行清洗和存储,去除重复和无用信息,将数据存储到数据库或者其他存储介质中,以便后续的数据分析和可视化。

具体算法:

- 时间序列分析模型:时间序列分析模型可以帮助企业分析招聘数据的趋势和周期性变化,以预测未来的招聘需求。这些模型可以通过回归分析、ARIMA模型、SARIMA模型等方法来预测未来的招聘数据。

- 机器学习模型:机器学习模型可以帮助企业预测未来的招聘需求和人才市场趋势,通过学习历史数据中的规律和模式来进行预测。例如,使用随机森林、神经网络、支持向量机等算法来预测未来的招聘需求和人才市场趋势。

- 聚类分析模型:聚类分析模型可以帮助企业将招聘数据中的相似特征进行聚类,从而预测相似特征的招聘数据的变化趋势。例如,通过聚类分析模型,可以将不同渠道的招聘数据按照相似的特征进行聚类,以预测不同渠道的招聘效果。

- 关联规则分析模型:关联规则分析模型可以帮助企业发现招聘数据之间的关联规则和规律,以预测未来的招聘需求和人才市场趋势。例如,通过关联规则分析模型,可以发现不同职位、不同薪资、不同地区之间的关联规则,以预测不同职位、薪资和地区的招聘效果。

- 基于深度学习的预测模型:基于深度学习的预测模型可以帮助企业更加准确地预测未来的招聘需求和人才市场趋势。例如,使用循环神经网络(RNN)和长短时记忆网络(LSTM)等深度学习算法来预测未来的招聘需求和人才市场趋势。